Où mène la suprématie en intelligence artificielle ≈059

La panoplie de programmes d’intelligence artificielle utilisée par les Forces de Défense d’Israël est assez puissante pour contribuer à transformer ceux qui l’utilisent. Mérite réflexion...

Les programmes d’intelligence artificielle dont s’est doté Israël aident à comprendre ce qui se passe au Moyen Orient depuis un an, en particulier au cours des dernières semaines et, sans doute, demain. On en parle peu mais une recherche un peu poussée permet d’en saisir l’ampleur et son impact sur l’évolution des pratiques de Tsahal à Gaza et au Liban, pour le moment.

« Nous inventons les outils. Ils nous transforment. Il en va ainsi depuis le galet biface qui, modifiant l’alimentation de ses inventeurs, a ouvert la voie à Homo Sapiens. Il y a 3 millions d’années. Pareil avec l’IA, sauf qu’il faut décider qui commande. » Ces phrases viennent de mon billet IA, politique et mythes grecs ≈014 et datent de Juillet 2023. Nous pouvons maintenant passer aux réalités du monde d’aujourd’hui.

De « L’Alchimiste » à « Où est papa ? », une panoplie de programmes d’IA

Israël dispose d’une panoplie de systèmes en constante interaction. Les plus connus sont :

« The Gospel » (Habsora en hébreu) repère les installations physiques à éliminer.

« Lavender » enregistre et traite toutes les données concernant les militants et combattants du Hamas (quand il s’agit de Gaza) et ceux qui sont sensés l’être.

« Where is Daddy? » détecte quand un cadre rentre chez lui pour l’y éliminer avec sa famille.

L’essentiel de ces informations ont été recueillies et publiées par le média indépendant et sans but lucratif +972 (numéro de code téléphonique partagé par Israël et les territoires palestiniens). Créé en 2010 par quatre journalistes israéliens et palestiniens progressistes. Il a été qualifié par Le Monde de « journal d’investigation ».

Qui doute de telles sources peut se référer à un article publié dans Vortex, revue de l’Armée de l’air française, en 2022 par le Dr Liran Antebi professeure à l’Israeli Air Force Academia, et commandante de réserve dans les forces aériennes israéliennes. Outre « The Gospel, » elle mentionne « The Alchemist », qui permet la détection de cibles en temps réel et « Depth of Wisdom », dont Libération nous dit : « L’outil intègre des fonctions d’analyse de vidéos, de reconnaissance faciale, de voix, de plaque d’immatriculation, d’analyses de données issues de médias sociaux, de pages non publiques du web, ainsi que des données de géolocalisation. Autant de fonctionnalités permettant d’établir des profils analysables par les autres IA précédemment évoquées. À cette liste nous devons ajouter « Fire Factory » mentionné par Bloomberg (avec capture d’écran) qui « vise à optimiser, en temps réel, les plans d’attaques des avions et des drones, en fonction de la nature des cibles choisies ».

Le Jerusalem Post a publié, le 11 octobre 2023, un entretien avec un colonel chef de « la banque de cibles » qui a déclaré que « les capacités de ciblage de l'IA avaient, pour la première fois, aidé les FDI (Forces de défense d’Israël) à atteindre le point où elles peuvent assembler de nouveaux objectifs encore plus rapidement que le rythme des attaques. »

Le même article citant des propos tenus par le général Omer Tishler, chef de l’aviation israélienne explique que « bien entendu, la FDI ne vise pas les civils comme l'a fait le Hamas en masse samedi [7 octobre] et comme il continue de le faire avec ses tirs de roquettes, il y a toujours une cible militaire, mais nous ne sommes pas chirurgicaux ». L'armée de l'air traque partout « des envahisseurs à quiconque met le nez dehors dans Gaza (steps outside in Gaza), en passant par les terroristes qui se cachent à l'intérieur des résidences [civiles] ».

En clair : tout peut être repéré, donc tout peut être détruit…

The Guardian cite Daniel Hagari, porte-parole des FDI (Forces de défense d’Israël), qui a déclaré le 9 octobre de la même année. "L'accent est mis sur les dégâts et non sur la précision ».

Selon le Jerusalem Post, le ministre de la défense a déclaré dès novembre 2023, « Ce que nous pouvons faire à Gaza, nous pouvons le faire à Beyrouth ».

Les travaux que j’utilise ici portent sur l'utilisation de l’IA dans les attaques menées en 2021 et après le 7 octobre 2023 contre Gaza. Je n'ai rien trouvé sur les opérations plus récentes contre le Liban, si ce n’est que leur style, leur précision et leur rythme tout à fait nouveau semble bien correspondre au même dispositif. Il y a une logique derrière tout ça.

Logique de l’instrument

Les théoriciens adorent inventer des « lois » qui ne sont en fait que des régularités, des hypothèses parfois confirmées. Je préfère parler de « logique », une notion moins contraignante mais à laquelle il est difficile d’échapper quand les conditions initiales sont réunies.

Celle à laquelle je m'intéresse aujourd'hui s'appelle la « Loi du marteau », une sorte de biais de jugement impliquant une confiance excessive, voire la dépendance d’un outil. Une de ses formulations consiste à dire « Donnez un marteau à un jeune garçon et il trouvera que tout a besoin d’être martelé », il verra ce qui l’entoure comme autant de clous. Qui ne s’en est jamais pris à une vis récalcitrante en lui donnant un bon coup sur la tête ? Les machines utilisant l’IA sont plus complexes que des marteaux, mais toute technologie transforme celui qui l’utilise… comme l’écriture nous a poussé vers la pensée linéaire.

Quand les clous ou les vis sont des vies humaines, la métaphore du chasse mouche semble mieux s’appliquer dans la mesure où il s’agit de se défaire d’entités vivantes qui gênent. Yoav Galant, ministre de la défense n’a-t-il pas déclaré publiquement « nous combattons des animaux humains et nous agissons en conséquence ». Il n’est pas le plus extrémiste de ce gouvernement qui donne les ordres auxquels tous les officiers cités obéissent.

Comment le recours à L’IA a transformé Tsahal

Revenons maintenant aux enquêtes menées par Yuval Abraham pour +972. Elles sont riches de réflexions d’officiers israéliens ayant participé au maniement de ces outils.

« Nous préparons les cibles automatiquement et travaillons selon une liste de contrôle", a déclaré l'une des sources ayant opéré dans la nouvelle Division administrative des cibles., peut-on lire dans un article publié au tout début de l’offensive israélienne en réponse à l’attaque du Hamas lancée le 7 octobre. "C'est vraiment comme une usine. [...] L'idée est que nous sommes jugés en fonction du nombre d'objectifs que nous parvenons à générer." Un ancien officier de renseignement a expliqué que le système Habsora permet à l'armée de gérer une "usine d'assassinats de masse", dans laquelle "l'accent est mis sur la quantité et non sur la qualité".

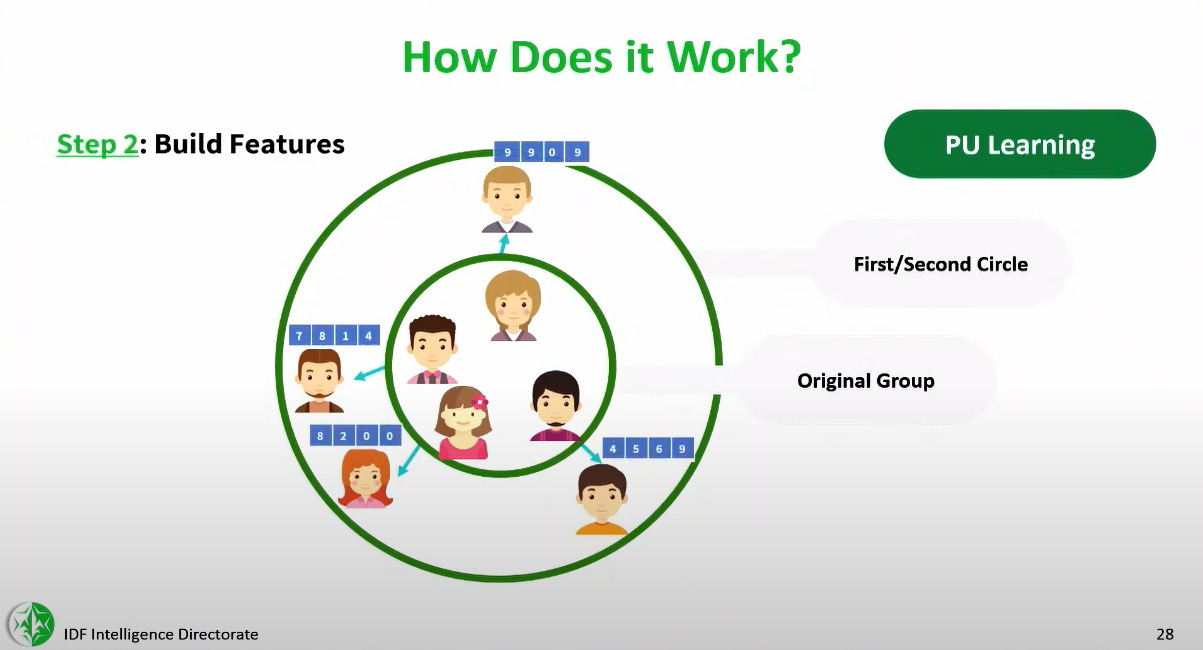

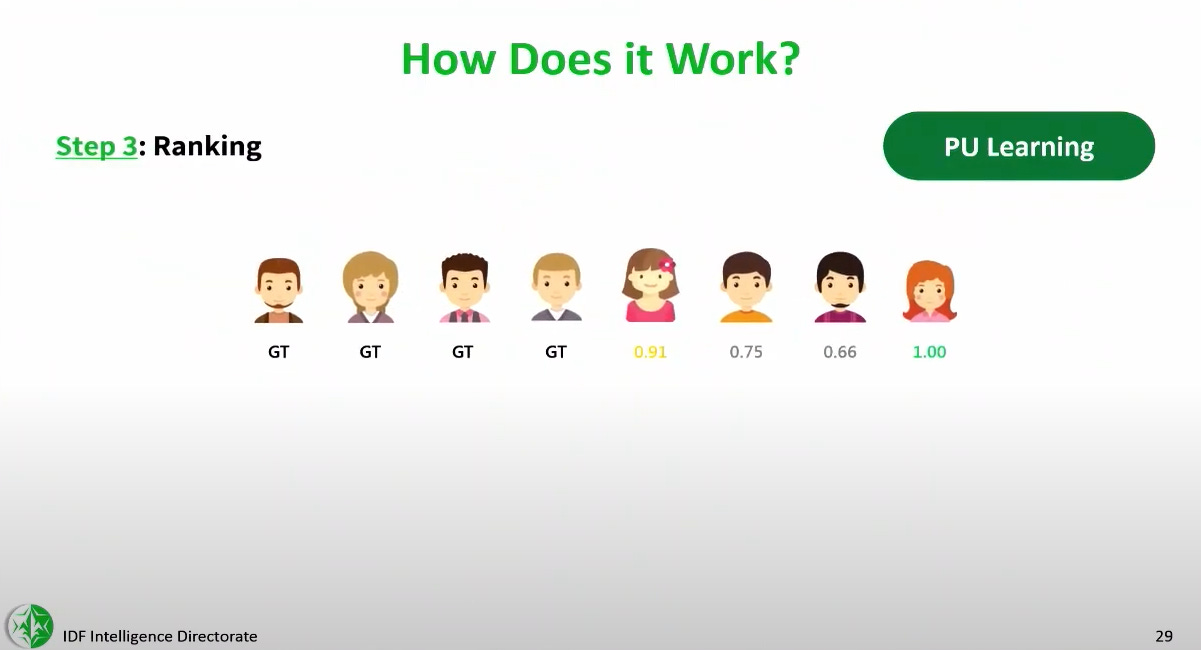

Lavender a été l’objet d’une enquête publiée en avril 2024 par le même journaliste. Il révèle que ce programme analyse les informations recueillies sur la plupart des 2,3 millions d'habitants de la bande de Gaza grâce à un système de surveillance de masse, puis évalue et classe la probabilité que chaque personne soit active dans l'aile militaire du Hamas ou du Jihad Islamique. Selon certaines sources la machine attribue à presque chaque habitant de Gaza une note de 1 à 100, exprimant la probabilité qu'il s'agisse d'un militant. Son influence sur les opérations militaires était telle qu'ils traitaient essentiellement les résultats de la machine d'IA "comme s'il s'agissait d'une décision humaine". Le personnel ne joue qu’un rôle d’appui ne consacrant pas plus d’environ « 20 secondes » à l’autorisation d’un bombardement sur une cible.

En quoi consiste la transformation ?

Selon ces sources, « au cours des guerres précédentes, les services de renseignement passaient beaucoup de temps à vérifier le nombre de personnes présentes dans une maison destinée à être bombardée. […] Après le 7 octobre, cette vérification minutieuse a été largement abandonnée au profit de l'automatisation. » Pour la FDI, l’intelligence artificielle s’impose ainsi comme la seule façon de faire face au « goulot d’étranglement » que représenterait le manque de personnel nécessaire pour « produire » le nombre de cibles voulu.

« Les erreurs étaient traitées statistiquement », a déclaré à Yuval Abraham une source qui a utilisé Lavender. "En raison de la portée et de l'ampleur du projet, le protocole était le suivant : même si l'on n'est pas sûr que la machine soit bonne, on sait que statistiquement, elle est bonne. Alors, on y va ». Commentaire d’un officier supérieur : « La machine l'a fait froidement. Et cela a facilité les choses ».